算力規(guī)模可以從模型復(fù)雜性、數(shù)據(jù)規(guī)模、硬件配置、任務(wù)類型和目標(biāo)性能等多個方面考慮,進(jìn)而更加準(zhǔn)確地預(yù)估AI算力規(guī)模。

1. 模型復(fù)雜性

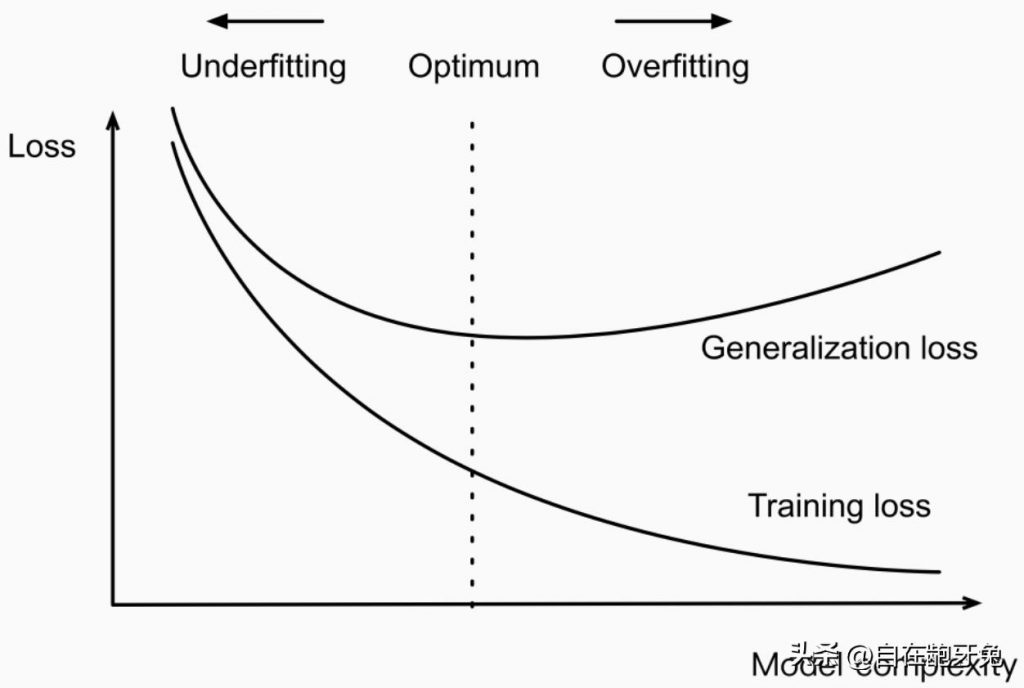

模型的復(fù)雜性通常由模型的參數(shù)數(shù)量和架構(gòu)決定。以下是一些常見的模型復(fù)雜性指標(biāo):

參數(shù)數(shù)量:參數(shù)越多,計算需求越高。

層數(shù):深層神經(jīng)網(wǎng)絡(luò)需要更多的計算。

算力需求:可以通過模型的FLOPs(每秒浮點(diǎn)運(yùn)算次數(shù))來衡量。

2. 數(shù)據(jù)規(guī)模

數(shù)據(jù)的規(guī)模對算力需求有直接影響,包括:

數(shù)據(jù)集大小:數(shù)據(jù)集越大,訓(xùn)練時間越長。

數(shù)據(jù)預(yù)處理:大規(guī)模數(shù)據(jù)預(yù)處理需要額外的計算資源。

3. 硬件配置

硬件配置直接決定了可用算力,包括:

- GPU數(shù)量和型號:不同GPU型號的計算能力差異很大。

- 內(nèi)存大小:足夠的內(nèi)存能保證模型訓(xùn)練和推理的順利進(jìn)行。

- 存儲速度:高效的存儲系統(tǒng)能加快數(shù)據(jù)讀取速度。

4. 任務(wù)類型

不同的任務(wù)類型對算力需求也不同:

- 訓(xùn)練 vs 推理:訓(xùn)練過程通常需要更多的計算資源。

- 實(shí)時性要求:實(shí)時推理需要更高的算力以確保低延遲。

5. 目標(biāo)性能

目標(biāo)性能包括模型的精度、訓(xùn)練時間和推理時間等:

- 精度要求:更高的精度可能需要更復(fù)雜的模型和更多的訓(xùn)練數(shù)據(jù)。

- 訓(xùn)練時間:快速訓(xùn)練需要更多的計算資源。

- 推理時間:實(shí)時應(yīng)用需要快速推理能力。

估算方法

步驟1:確定模型參數(shù)

確定你所使用的模型架構(gòu)及其參數(shù)數(shù)量。例如,一個BERT模型有約110M參數(shù)。

步驟2:計算模型的FLOPs

估算模型訓(xùn)練和推理所需的FLOPs。例如,BERT-base每次前向和后向傳播大約需要180億FLOPs。

步驟3:確定數(shù)據(jù)規(guī)模

計算整個數(shù)據(jù)集的總數(shù)據(jù)量。例如,如果數(shù)據(jù)集有1億條樣本,每條樣本大小為1KB,總數(shù)據(jù)量為100GB。

步驟4:選擇硬件配置

選擇適當(dāng)?shù)挠布渲茫鏕PU型號及數(shù)量。例如,NVIDIA V100 GPU每秒可以執(zhí)行125萬億FLOPs。

步驟5:估算訓(xùn)練時間

根據(jù)模型FLOPs、數(shù)據(jù)規(guī)模和硬件性能,估算訓(xùn)練時間。例如,訓(xùn)練BERT-base模型可能需要10天在8個V100 GPU上完成。

示例

假設(shè)你要訓(xùn)練一個BERT-base模型,以下是詳細(xì)的估算步驟:

- 模型參數(shù):110M

- 每次前向和后向傳播FLOPs:180億

- 數(shù)據(jù)集大小:100GB【假設(shè)每個樣本大小=100KB,那么就有100萬個樣本,即樣本數(shù)量=數(shù)據(jù)集總大小(MB)/每個樣本大小(MB)】

- GPU型號:NVIDIA V100

- 每個GPU的FLOPs:125 TFLOPs

- 訓(xùn)練周期:10 epochs

- 數(shù)據(jù)讀取速度:需要考慮,但假設(shè)可以忽略不計

計算每次迭代的FLOPs:每次迭代FLOPs = 180 × 10^9

計算總訓(xùn)練FLOPs:總訓(xùn)練FLOPs = 每次迭代FLOPs × 數(shù)據(jù)集大小 × 訓(xùn)練周期

計算訓(xùn)練時間:訓(xùn)練時間 = 總訓(xùn)練FLOPs / (每個GPU的FLOPs × GPU數(shù)量)

假設(shè)你的數(shù)據(jù)集有100萬個樣本,每次迭代計算需要180億FLOPs,訓(xùn)練10個周期:

總訓(xùn)練FLOPs = 180 × 10^9(每次迭代FLOPs) × 1× 10^6(樣本數(shù)量) × 10(訓(xùn)練周期) = 1.8 × 10^18

訓(xùn)練時間 = (1.8 × 10^18) / (125 × 10^12 × 8)≈ 1.8 × 10^3秒 = 30 分鐘

附

- 什么是訓(xùn)練周期(epoch)?

它指的是整個訓(xùn)練數(shù)據(jù)集被完整地送入模型一次的過程。換句話說,1個epoch?就是模型在整個訓(xùn)練數(shù)據(jù)集上訓(xùn)練一次。

- 訓(xùn)練數(shù)據(jù)集:這是用于訓(xùn)練模型的數(shù)據(jù)集合,包含了輸入數(shù)據(jù)和對應(yīng)的標(biāo)簽。

- 批次(Batch):由于數(shù)據(jù)集可能非常大,通常不會一次性將整個數(shù)據(jù)集送入模型,而是分成多個小批次。每個批次稱為一個batch。

- 步驟(Step):在每個batch上進(jìn)行一次前向傳播和后向傳播稱為一個step。

- epoch:當(dāng)所有的batch都完成了一次訓(xùn)練,這個過程稱為一個epoch。

假設(shè)你的訓(xùn)練數(shù)據(jù)集有1000個樣本,你選擇每個batch包含100個樣本,那么:

- 1個epoch包含10個batch(因?yàn)?1000÷100=10)。

如果你設(shè)定訓(xùn)練10個epoch,那么整個訓(xùn)練過程中:

- 你的模型將看到并處理訓(xùn)練數(shù)據(jù)集10次。

- 總共將進(jìn)行100次step(因?yàn)?10×10=100)。

什么是模型參數(shù)(訓(xùn)練參數(shù))?

想象你在學(xué)習(xí)如何烘焙蛋糕,模型參數(shù)就像是你調(diào)整配方中的各個成分比例(比如面粉、糖、黃油、雞蛋等)的量度。每次你做蛋糕(訓(xùn)練模型),你會根據(jù)結(jié)果(蛋糕的味道和外觀)來調(diào)整這些成分的量度,使得下一次的蛋糕更好。

- 權(quán)重(Weights):就像是每種成分的量。你可以認(rèn)為每種成分對蛋糕的最終味道都有不同的影響。

- 偏置(Biases):就像是烘焙環(huán)境的微調(diào),比如烤箱的溫度。即使成分量一樣,不同的溫度會對蛋糕的最終效果有不同的影響。

每次你烘焙蛋糕(訓(xùn)練一次模型),你會根據(jù)結(jié)果調(diào)整這些成分的量度(模型參數(shù)),以使蛋糕更好(模型更準(zhǔn)確)。

數(shù)據(jù)集和樣本數(shù)量有什么區(qū)別?

我們可以用一個圖書館的比喻:

- 數(shù)據(jù)集大小:

- 數(shù)據(jù)集大小可以理解為圖書館中所有書籍的總重量(或總字?jǐn)?shù))。

- 如果你有一個100GB的數(shù)據(jù)集,就像你有一個裝滿了書籍的圖書館。

- 樣本數(shù)量:

- 樣本數(shù)量是圖書館中書籍的總數(shù)量。

- 每本書代表數(shù)據(jù)集中的一個樣本,例如一張圖片、一段文本等。

- 如果圖書館有1000本書,那么樣本數(shù)量就是1000。

域名頻道是專業(yè)從事虛擬主機(jī)租用和申請服務(wù)的專業(yè)網(wǎng)站。

因此用戶自己購買服務(wù)器后,將其放置到IDC機(jī)房中運(yùn)行。而提供這一互聯(lián)網(wǎng)服務(wù)則成為服務(wù)器托管。

域名頻道針對數(shù)據(jù)庫管理都有明確指導(dǎo),MY SQL數(shù)據(jù)庫開通后可以通過phpmyadmin軟件進(jìn)行管理。phpmyadmin軟件可以直接從網(wǎng)絡(luò)上下載后上傳到您的虛擬主機(jī)空間中即可。

來域名頻道選擇專業(yè)的獨(dú)立服務(wù)器托管服務(wù),詳情鏈接點(diǎn)擊http://www.rmdipyo.com/server/trusteehost.asp

域名頻道IDC知識庫

域名頻道IDC知識庫